Qu’est-ce que le cloaking en SEO ? WhiteHat ? BlackHat ? | Tactee

- Qu’est-ce qui se cache derrière le cloaking ?

- Les différentes techniques de cloaking

- Le cloaking basé sur le user-agent

- Le cloaking « IP Delivery » basé sur l’adresse IP

- Le cloaking via Javascript, Flash ou Dhtml

- Le cloaking du texte ou du bloc invisible

- Le cloaking basé sur l’hôte

- Le cloaking dans le référencement SEO : white ou black hat ?

- Le cloaking est-il une pratique recommandable ?

Qu’est-ce qui se cache derrière le cloaking ?

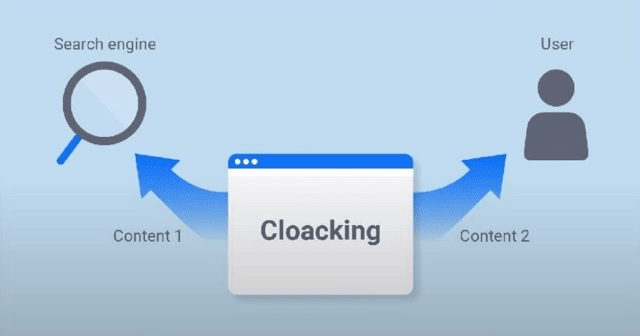

Le cloaking est une technique utilisée par les référenceurs SEO qui souhaite obtenir des performances rapidement. Généralement cette méthode est peu développée en agence SEO car elle peut être assez dangereuse d’un point de vue pénalité Google. En effet, celle-ci consiste à adapter le comportement d’un site en fonction du visiteur qui vient chercher l’information sur le serveur.

Si le visiteur est un être humain, le contenu du site sur lequel il va atterrir ne sera pas le même que si la demande provient d’un robot d’exploration (Googlebot, Bingbot pour ne citer qu’eux). Dans ce dernier cas, le site utilisant le cloaking va automatiquement s’adapter aux exigences du robot en général Googlebot et lui présenter une page différente avec la page qui sera montrée à l’internaute.

Cette méthode avancée est parfois utilisée en référencement SEO car elle permet d’améliorer votre PageRank (système de classement mis en place par Google et qui évalue la popularité de votre site). Elle vise à camoufler aux moteurs la vraie page qui s’affichera sur l’écran d’un utilisateur en leur présentant une page différente, spécialement optimisée pour les robots.

A court terme, le cloaking peut se montrer utile pour mieux se positionner mais les dérives sont nombreuses et Google veille au grain.

Ne vous est-il jamais arrivé de tomber sur un site pornographique alors que vous souhaitiez simplement choisir la destination de vos prochaines vacances ? Expérience peu agréable s’il en est, c’est pourquoi Google interdit formellement le cloaking et n’hésite pas à sanctionner les sites qui y recourent.

Les différentes techniques de cloaking

Lorsqu’un utilisateur se connecte à un site, son navigateur envoie une requête http au serveur du site. Cette requête va afficher divers éléments parmi lesquels le user-agent, l’hôte ou encore l’adresse IP.

Quand le serveur reçoit la requête http, il va charger ou générer la page demandée par l’internaute. Cette page, qui est en langage serveur (php, asp…), est ensuite adressée au navigateur qui va la traduire pour la rendre lisible par l’utilisateur.

Concrètement, cela veut dire qu’un site peut vous faire parvenir la page qu’il veut en fonction des différents éléments d’identification transmis lors d’une requête sur internet.

Il existe plusieurs méthodes de cloaking basées sur différents supports. Les référenceurs utilisent principalement la méthode du « user-agent ». Ils peuvent également utiliser d’autres méthodes plus ou moins détectables par Google.

Le cloaking basé sur le user-agent

Le user-agent est une en-tête http envoyée par le visiteur qui fait une requête sur une page. Lors d’une connexion, le navigateur utilisé (Firefox, Safari, Explorer, Chrome…) envoie au serveur un texte qui va identifier ce dernier. Au-delà des navigateurs, il peut également être identifié par des spiders, bots, robots et crawlers utilisés par les moteurs de recherche.

La méthode de cloaking consiste alors à agir sur le contenu de la page dès lors que cet en-tête est détecté comme étant un un robot d’exploration.

Le cloaking « IP Delivery » basé sur l’adresse IP

Cette méthode de cloaking s’appuie sur la détection de l’adresse IP (Internet Protocol), c’est-à-dire une suite de chiffres qui regroupe un ensemble d’appareils connectés à internet. Par exemple, les membres d’une famille qui possède une box internet seront tous reliés à la même adresse IP.

Une adresse IP permet notamment de savoir dans quel pays se trouve l’internaute. Un cloaking basé sur l’adresse IP va donc adapter le contenu à la langue identifiée.

Mais une adresse IP peut aussi détecter un robot d’indexation. Un cloaker aura alors pour mission de créer une page super-optimisée pour leurrer le robot en lui faisant croire que sa page propose un contenu très riche alors que la page réellement vue par l’internaute sera très différente.

Le cloaking via Javascript, Flash ou Dhtml

Les cloakers ont également compris que les moteurs de recherche avaient plus de mal à cerner les langages Javascript, Flash ou Dhtml. La méthode de cloaking qui utilise ces codes est donc plus difficile à débusquer. Le cloaker va remplir des pages de mots-clés qui viseront à être bien classées par les moteurs. Mais ces pages codées seront en réalité redirigées vers d’autres pages plus classiques qui remonteront jusqu’à l’internaute par l’intermédiaire de son navigateur.

Le cloaking du texte ou du bloc invisible

C’est la plus ancienne méthode de cloaking, désormais facilement identifiable par les moteurs et les utilisateurs. Elle consiste à mettre du texte invisible pour l’internaute (par exemple un texte noir sur fond noir) mais qui sera pris en compte par les moteurs de recherche. C’est souvent une liste de mots-clés qui permet d’obtenir un meilleur classement dans les résultats de recherche. Le cloaker peut également positionner un bloc invisible sur un autre bloc visible par l’internaute et y inscrire les mots-clés qui seront valorisés par les moteurs de recherche.

Le cloaking basé sur l’hôte

Encore plus efficace (et donc plus redoutable) que le cloaking basé sur l’adresse IP, le cloaking basé sur l’hôte va cibler directement le serveur sur lequel l’utilisateur se connecte pour aller sur internet. Grâce à cette technique, il est possible de détecter les différents serveurs de Google.

Le cloaking dans le référencement SEO : white ou black hat ?

Le référencement SEO peut se présenter sous deux casquettes différentes : le white hat (la version sage et disciplinée) et le black hat (la version obscure et transgressive). Le cloaking est clairement l’apanage des SEO black hat. A vous de voir quel chapeau vous souhaitez porter…

- Le SEO white hat est une forme de référencement qui répond aux exigences des moteurs de recherche, principalement Google. Il s’agit de fournir un contenu de qualité que les référenceurs optimiseront au mieux pour améliorer le classement de leur site dans les résultats de recherche. Cette stratégie de contenu vise une qualité de référencement à long terme et en toute transparence. Il va de soi que c’est ce type de référencement qui sera privilégié pour garantir la réputation d’un site durablement.

- Le SEO black hat, quant à lui, vise le court terme et va chercher à détourner les algorithmes des moteurs pour obtenir rapidement de meilleurs classements. Il va donc employer des méthodes proscrites par les moteurs en indexant des pages différentes de celles qui seront vues par les internautes. Ils vont par exemple utiliser des scripts php qui vont afficher des contenus différents selon le type de destinataire. Ce type de référencement peut sembler très tentant car les résultats sont rapides mais c’est à vos risques et périls. Si vous êtes pris la main dans le sac par Google, votre réputation risque d’en prendre un sérieux coup.

Le cloaking est-il une pratique recommandable ?

Pour Google, il n’y a pas de demi-mesure, le cloaking est totalement interdit.

La sanction peut aller d’une rétrogradation dans le classement à un blocage du site.

De grandes entreprises en ont fait les frais comme BMW en 2006. Résultat : leurs sites « cloakés » ont été tout simplement supprimés par Google.

Pour tenter de débusquer les tricheurs, Google a mis en place des robots masqués qui parcourent internet en se faisant passer pour des humains. Les résultats de ces robots sont croisés avec ceux des robots traditionnels et ainsi, les pages cloakées peuvent être démasquées.

Par ailleurs Google incite tous les utilisateurs et référenceurs qui se sentent floués par ces méthodes, à dénoncer les sites qui utilisent le cloaking.